Llama 3은 Meta의 최신 대형 언어 모델입니다. 쿼리 해결, 학교 숙제 및 프로젝트에 대한 도움 받기 등 다양한 목적으로 사용할 수 있습니다. Windows 11 컴퓨터에 로컬로 Llama 3를 배포하면 인터넷에 액세스하지 않고도 언제든지 사용할 수 있습니다. 이 기사에서는 Windows 11 PC에 Llama 3를 설치하는 방법 .

Windows 11 PC에 Llama 3를 설치하는 방법

Python을 통해 Windows 11 PC에 Llama 3를 설치하려면 기술과 지식이 필요합니다. 그러나 일부 대체 방법을 사용하면 Windows 11 시스템에 Llama 3를 로컬로 배포할 수 있습니다. 이러한 방법을 보여 드리겠습니다.

Windows 11 PC에 Llama 3를 설치하려면 명령 프롬프트에서 일부 명령을 실행해야 합니다. 그러나 이렇게 하면 명령줄 버전만 사용할 수 있습니다. 웹 UI를 사용하려면 추가 단계를 수행해야 합니다. 이 두 가지 방법을 모두 보여 드리겠습니다.

CMD를 통해 Windows 11 PC에 Llama 3 배포

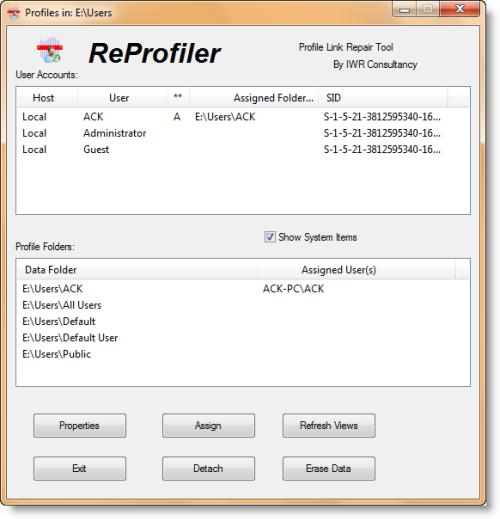

Windows 11 PC에 Llama 3를 배포하려면 Windows 컴퓨터에 Ollama를 설치해야 합니다. 동일한 단계는 다음과 같습니다.

- 방문하다 올라마 공식 홈페이지 .

- 다음을 클릭하세요. 다운로드 버튼을 누른 다음 선택하세요. 윈도우 .

- 이제 Windows용 다운로드 버튼을 눌러 exe 파일을 PC에 저장하세요.

- exe 파일을 실행하여 컴퓨터에 Ollama를 설치하세요.

Ollama가 장치에 설치되면 컴퓨터를 다시 시작하십시오. 백그라운드에서 실행 중이어야 합니다. 시스템 트레이에서 볼 수 있습니다. 이제 Ollama 웹사이트에서 모델 옵션을 클릭하세요. 다양한 모델을 보실 수 있습니다.

Llama 3.1은 다음 세 가지 매개변수로 사용할 수 있습니다.

robocopy GUI 창 10

- 8B

- 70B

- 405B

마지막 매개변수는 가장 큰 매개변수이며 분명히 저사양 PC에서는 실행할 수 없습니다. Llama 3.2에는 다음 두 가지 매개변수가 있습니다.

- 1B

- 3B

PC에 설치하려는 Llama 버전을 클릭합니다. 예를 들어 Llama 3.2를 설치하려면 Llama 3.2를 클릭합니다. 드롭다운에서 설치하려는 매개변수를 선택할 수 있습니다. 그런 다음 옆에 있는 명령을 복사하여 명령 프롬프트에 붙여넣습니다.

귀하의 편의를 위해 Llama 3.2 모델에 대한 두 명령을 모두 작성했습니다. Llama 3.2 3B 모델을 설치하려면 다음 명령을 실행하십시오.

ollama run llama3.2:3b

Llama 3.2 1B 모델을 설치하려면 다음 명령을 사용하십시오.

ollama run llama3.2:1b

명령 프롬프트를 열고 위에서 언급한 명령 중 하나를 입력하고(요구 사항에 따라) 입력하다 . 필요한 파일을 다운로드하는데 시간이 좀 걸립니다. 다운로드 시간은 인터넷 연결 속도에 따라 달라집니다. 완료 후, 당신은 볼 수 있습니다 성공 명령 프롬프트의 메시지.

이제 Llama 3.2 모델을 사용하려면 메시지를 입력하세요. Llama 3.1 모델을 설치하려면 Ollama 웹사이트에서 제공되는 명령을 사용하세요.

다음에 명령 프롬프트를 시작할 때 동일한 명령을 사용하여 PC에서 Llama 3.1 또는 3.2를 실행하세요.

CMD를 통해 Llama 3를 설치하면 한 가지 단점이 있습니다. 채팅 기록은 저장되지 않습니다. 그러나 로컬 호스트에 배포하면 채팅 기록이 저장되고 더 나은 사용자 인터페이스를 얻을 수 있습니다. 다음 방법에서는 그 방법을 보여줍니다.

Windows 11에 Llama 3 웹 UI 배포

웹 브라우저에서 Llama 3를 사용하면 CMD 창에서 사용할 때보다 더 나은 사용자 인터페이스를 제공하고 채팅 기록도 저장됩니다. 웹 브라우저에 Llama 3를 배포하는 방법을 보여 드리겠습니다.

웹 브라우저에서 Llama 3를 사용하려면 Ollama 및 Docker를 통한 Llama 3가 시스템에 설치되어 있어야 합니다. 아직 Llama 3를 설치하지 않았다면 Ollama를 사용하여 설치하세요(위 설명대로). 이제 Docker를 다운로드하여 설치하십시오. 공식 웹사이트 .

Docker를 설치한 후 실행하고 가입하여 계정을 만드세요. Docker는 등록할 때까지 실행되지 않습니다. 가입 후 Docker 앱에서 계정에 로그인하세요. Docker를 시스템 트레이로 최소화합니다. Docker 및 Ollama 앱이 백그라운드에서 실행되어야 합니다. 그렇지 않으면 웹 브라우저에서 Llama 3를 사용할 수 없습니다.

이제 명령 프롬프트를 열고 다음 명령을 복사하여 명령 프롬프트에 붙여넣습니다.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

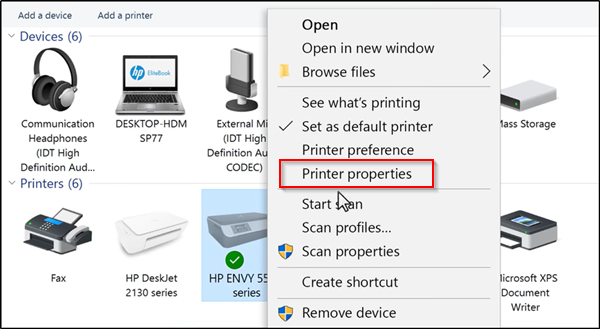

위 명령은 필요한 리소스를 다운로드하는 데 시간이 걸립니다. 그러므로 인내심을 가지십시오. 명령 완료 후 Docker를 열고 다음을 선택하십시오. 컨테이너 왼쪽부터 섹션. 포트 3000:8080을 사용하여 컨테이너가 자동으로 생성되는 것을 볼 수 있습니다.

포트 3000:8080을 클릭하세요. 그러면 기본 웹 브라우저에 새 탭이 열립니다. 이제 웹 브라우저에서 Llama 3를 사용하려면 가입하고 로그인하세요. 주소창을 보시면 아시겠지만 로컬호스트:3000 이는 Llama 3가 사용자의 컴퓨터에서 로컬로 호스팅된다는 의미입니다. 인터넷에 연결하지 않고도 사용할 수 있습니다.

드롭다운에서 Llama 채팅 모델을 선택하세요. Llama 3의 채팅 모델을 더 추가하려면 필수 명령을 사용하여 Ollama를 통해 설치해야 합니다. 그 후에는 웹 브라우저에서 모델을 자동으로 사용할 수 있습니다.

모든 채팅 기록은 저장되며 왼쪽에서 액세스할 수 있습니다. 종료하려면 웹 브라우저에서 세션을 로그아웃하십시오. 그런 다음 Docker 앱을 열고 다음을 클릭하십시오. 멈추다 Docker를 중지하는 버튼입니다. 이제 Docker를 닫을 수 있습니다.

3D Builder Windows 10 사용 방법

다음에 웹 브라우저에서 Llama 3를 사용하려면 Ollama와 Docker를 실행하고 몇 분 동안 기다린 후 Docker 컨테이너의 포트를 클릭하여 웹 브라우저에서 localhost 서버를 엽니다. 이제 계정에 로그인하여 Llama 3를 사용해 보세요.

이것이 도움이 되기를 바랍니다.

Llama 3를 Windows에서 실행할 수 있나요?

컴퓨터의 하드웨어 구성에 따라 시스템에서 Llama 3를 실행할 수 있습니다. 1B 모델이 가장 가볍습니다. 명령 프롬프트를 통해 시스템에 설치하고 실행할 수 있습니다.

Llama 3에는 RAM이 얼마나 필요합니까?

Llama 3의 가장 가벼운 모델은 Llama 3.2 1B입니다. Llama 3.2 1B 모델을 실행하려면 시스템에 16GB RAM이 있어야 합니다. 이 외에도 시스템에는 강력한 GPU가 있어야 합니다. Llama 3의 상위 모델에는 더 많은 시스템 리소스가 필요합니다.

다음 읽기 : 레오나르도 피닉스 AI를 사용하는 방법 .

![Hulu 로그인이 작동하지 않음 [고정됨]](https://prankmike.com/img/hulu/52/hulu-login-not-working-fixed-1.png)